ロボットの視野内に遮蔽物が存在したり、予期せぬ力が加わった場合でも、柔軟かつ安定に動作することを椅子の組立作業において実証

2024年2月21日

株式会社日立製作所

日立は、社会インフラ設備の組立や保守作業の自動化を推進するため、作業時の視覚や力覚*1といったマルチモーダル*2なセンサ情報の重要度を、作業内容や環境に応じてリアルタイムに切り替える技術を開発しました。

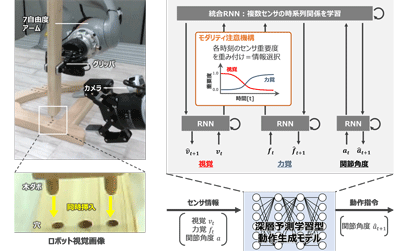

これまで日立は、早稲田大学理工学術院の尾形 哲也(おがた てつや)教授の研究グループと共同で、作業内容や環境が変化しても行動をリアルタイムに決定・実行可能な深層予測学習型のロボット制御技術を開発してきました*3。今回、日立は、狭い空間内で部品をはめ込むような難作業や、部品が大型の場合に死角が生じる作業の自動化に向けて、視覚の制約が生じる際に作業者が手先の感覚(力覚)を頼りにする傾向に着目し、視覚や力覚などマルチモーダルなセンサ情報の重要度を作業の内容や環境に応じてリアルタイムに切り替える技術を開発しました(図1)。この技術により、ロボットの視野内に遮蔽物が存在する、または計画時には存在しなかった力が加わる、という想定外の場合にも、柔軟かつ安定に動作可能であることを、椅子の組立作業において実証しました。

今後、組立や保守作業の計画から実行に至る一連の業務支援ソリューションを構築し、社会インフラ領域における労働力不足の解決に向けた取り組みを加速していきます。

本成果の一部は、国際会議The 2023 International Conference on Robotics and Automation (ICRA 2023)、国際学術誌IEEE Robotics and Automation Lettersに掲載されました。

なお、ロボット動作の学習に、国立研究開発法人産業技術総合研究所のAI橋渡しクラウド(ABCI)を活用しました。

図1:ロボットが視覚と力覚のセンサ情報の重要度を作業の内容や環境に応じてリアルタイムに切り替える技術

(人がロボットに所望の動作を複数回教示するだけで、センサ情報の重要度を学習し、

作業の内容や環境に応じて特定のセンサ情報に着目して作業を実行することが可能)

開発した技術の詳細は、こちら